Nginx实战宝典:15个真实场景的生产级解决方案

作为一名后端开发者,你是否曾经为服务器性能瓶颈而头疼?是否想过如何让你的网站在高并发下依然稳如泰山?今天,我们就来深入探讨这个被全球超过40%网站采用的Web服务器——Nginx。

这不是一篇简单的配置教程,而是一次从原理到实战的完整旅程。无论你是刚接触Nginx的新手,还是想要进一步优化系统性能的老手,这篇文章都会给你带来收获。

目录导航

基础篇

- 一、性能怪兽 - Nginx核心概念解析

- 二、环境搭建 - 从零开始部署Nginx

实战场景篇

- 三、场景1:反向代理与负载均衡 - 让流量智能分发

- 四、场景2:动静分离 - 提升网站响应速度的关键

- 五、场景3:资源压缩 - 节省74%的网络流量

- 六、场景4:缓冲区优化 - 优化数据传输效率

- 七、场景5:缓存机制 - 减轻后端服务器压力

- 八、场景6:IP黑白名单 - 构建安全防护体系

- 九、场景7:跨域配置 - 解决前后端分离难题

- 十、场景8:防盗链设计 - 保护资源防止盗用

- 十一、场景9:大文件传输 - 处理GB级文件下载

- 十二、场景10:SSL证书配置 - 实现HTTPS加密访问

- 十三、场景11:高可用架构 - 99.99%的服务可用性

- 十四、场景12:性能优化 - 实现7倍性能提升

总结篇

- 十五、实战经验总结与最佳实践

全文约7000字,预计阅读时间:18分钟

建议收藏后慢慢消化,每个场景都值得反复实践

一、性能怪兽:Nginx概念深入浅出

Nginx(发音为"engine-x")诞生于2004年,由俄罗斯程序员Igor Sysoev开发。它的设计初衷就是为了解决C10K问题——即如何在单台服务器上同时处理10000个并发连接。

为什么Nginx如此高效?

与传统的Apache采用进程/线程模型不同,Nginx使用异步非阻塞的事件驱动架构。这意味着什么?

想象一下传统餐厅的服务模式:每位服务员(线程)负责一桌客人,必须等这桌客人吃完才能服务下一桌。而Nginx就像一个高效的餐厅经理,多位服务员同时接单、上菜,哪个环节准备好了就立即处理,从不空等。

这种架构带来的优势是:

- 内存占用极低:处理10000个连接可能只需要2.5MB内存

- CPU消耗少:单个worker进程可以处理数千个并发连接

- 高并发能力强:轻松应对百万级并发

核心概念快速掌握

Nginx采用模块化设计,主要包含:

- Master进程:管理worker进程,读取配置文件

- Worker进程:实际处理请求

- 事件模块:epoll/kqueue等高效IO模型

- HTTP核心模块:处理HTTP协议相关功能

二、Nginx环境搭建

工欲善其事,必先利其器。让我们从零开始搭建Nginx环境。

Linux环境安装(推荐)

# Ubuntu/Debian

sudo apt update

sudo apt install nginx -y

# CentOS/RHEL

sudo yum install epel-release -y

sudo yum install nginx -y

# 启动服务

sudo systemctl start nginx

sudo systemctl enable nginx

源码编译安装(适合自定义需求)

# 下载最新稳定版

wget http://nginx.org/download/nginx-1.24.0.tar.gz

tar -zxvf nginx-1.24.0.tar.gz

cd nginx-1.24.0

# 编译安装

./configure --prefix=/usr/local/nginx \

--with-http_ssl_module \

--with-http_v2_module \

--with-http_realip_module \

--with-http_gzip_static_module

make && sudo make install

验证安装

nginx -v # 查看版本

nginx -t # 测试配置文件

访问 http://your-server-ip,看到Nginx欢迎页面即表示安装成功。

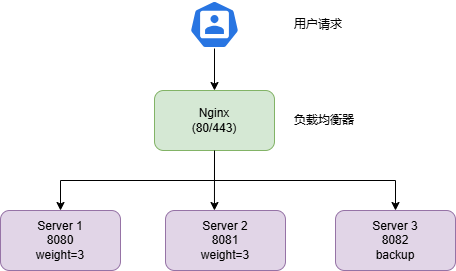

三、Nginx反向代理与负载均衡

反向代理是Nginx最常用的功能之一。它像一个智能的流量调度员,将用户请求分发到后端服务器。

基础反向代理配置

server {

listen 80;

server_name example.com;

location / {

proxy_pass http://localhost:8080;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

}

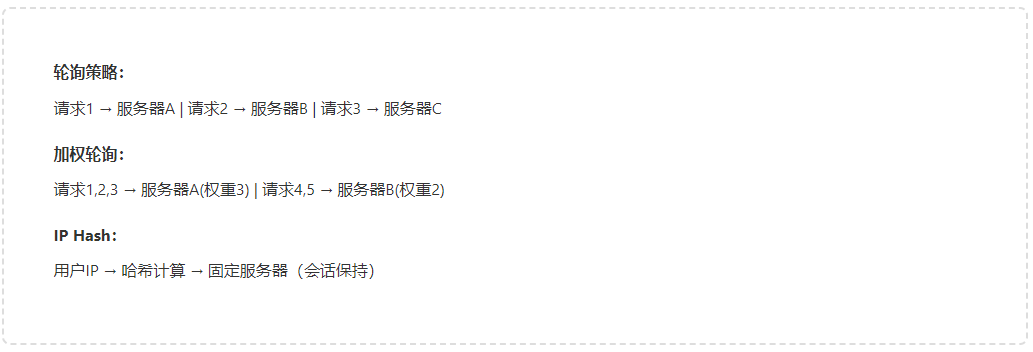

负载均衡策略详解

Nginx提供多种负载均衡算法:

1. 轮询(默认)

upstream backend {

server 192.168.1.10:8080;

server 192.168.1.11:8080;

server 192.168.1.12:8080;

}

2. 加权轮询

upstream backend {

server 192.168.1.10:8080 weight=3;

server 192.168.1.11:8080 weight=2;

server 192.168.1.12:8080 weight=1;

}

3. IP哈希(会话保持)

upstream backend {

ip_hash;

server 192.168.1.10:8080;

server 192.168.1.11:8080;

}

4. 最少连接

upstream backend {

least_conn;

server 192.168.1.10:8080;

server 192.168.1.11:8080;

}

健康检查配置

upstream backend {

server 192.168.1.10:8080 max_fails=3 fail_timeout=30s;

server 192.168.1.11:8080 max_fails=3 fail_timeout=30s;

server 192.168.1.12:8080 backup; # 备用服务器

}

四、Nginx动静分离

动静分离是提升网站性能的关键策略。简单来说,就是让Nginx直接处理静态资源(CSS、JS、图片等),而将动态请求转发给后端应用服务器。

为什么需要动静分离?

- 静态资源不需要后端处理,Nginx处理速度更快

- 减轻应用服务器压力,专注业务逻辑

- 便于实现CDN加速和缓存策略

实战配置

server {

listen 80;

server_name example.com;

# 静态资源目录

root /var/www/html;

# 处理静态文件

location ~ .*\.(html|htm|gif|jpg|jpeg|bmp|png|ico|txt|js|css|woff|woff2|ttf)$ {

root /var/www/static;

expires 7d; # 缓存7天

access_log off; # 关闭访问日志

}

# 动态请求转发

location ~ .*\.(php|jsp|do|action)$ {

proxy_pass http://backend;

proxy_set_header Host $host;

}

# API接口

location /api/ {

proxy_pass http://backend;

}

}

优化建议

- 静态资源使用独立域名(如static.example.com),避免cookie传输

- 合理设置过期时间,平衡更新频率和缓存效果

- 大文件单独处理,避免占用worker进程

五、Nginx资源压缩

启用Gzip压缩可以显著减少传输数据量,尤其对文本类资源效果明显。一个1MB的JS文件压缩后可能只有200KB。

完整压缩配置

http {

# 开启gzip压缩

gzip on;

# 压缩级别(1-9),级别越高压缩率越大但CPU消耗也越高

gzip_comp_level 6;

# 小于1KB的文件不压缩

gzip_min_length 1k;

# 压缩缓冲区

gzip_buffers 4 16k;

# HTTP协议版本

gzip_http_version 1.1;

# 压缩类型

gzip_types text/plain text/css application/json application/javascript

text/xml application/xml application/xml+rss text/javascript

application/x-font-ttf font/opentype image/svg+xml;

# 在响应头中添加Vary: Accept-Encoding

gzip_vary on;

# 禁用IE6的gzip

gzip_disable "MSIE [1-6]\.";

# 反向代理时的压缩

gzip_proxied any;

}

性能测试对比

未压缩前:

- HTML文件: 50KB

- CSS文件: 120KB

- JS文件: 300KB

- 总计: 470KB

压缩后:

- HTML文件: 12KB (76%压缩率)

- CSS文件: 25KB (79%压缩率)

- JS文件: 85KB (72%压缩率)

- 总计: 122KB (节省74%流量)

六、Nginx缓冲区

缓冲区机制可以优化Nginx与后端服务器、客户端之间的数据传输效率。

核心缓冲区配置

http {

# 客户端请求缓冲

client_body_buffer_size 128k; # 请求body缓冲

client_header_buffer_size 4k; # 请求头缓冲

large_client_header_buffers 4 8k; # 大请求头缓冲

client_max_body_size 10m; # 最大请求体大小

# 代理缓冲配置

proxy_buffering on; # 开启代理缓冲

proxy_buffer_size 4k; # 响应头缓冲

proxy_buffers 8 4k; # 响应体缓冲

proxy_busy_buffers_size 8k; # 忙碌缓冲区大小

proxy_temp_file_write_size 64k; # 临时文件大小

# FastCGI缓冲(PHP应用)

fastcgi_buffer_size 64k;

fastcgi_buffers 4 64k;

fastcgi_busy_buffers_size 128k;

}

如何选择合适的缓冲区大小?

- 根据实际请求大小调整

- 监控内存使用情况

- 考虑并发连接数

- 避免过大导致内存浪费

七、Nginx缓存机制

合理的缓存策略可以大幅减少后端压力,提升响应速度。

缓存命中流程

代理缓存配置

http {

# 定义缓存路径和参数

proxy_cache_path /var/cache/nginx/proxy

levels=1:2

keys_zone=my_cache:10m

max_size=1g

inactive=60m

use_temp_path=off;

server {

location / {

proxy_pass http://backend;

# 使用缓存

proxy_cache my_cache;

# 缓存状态码和时间

proxy_cache_valid 200 304 12h;

proxy_cache_valid 301 302 1h;

proxy_cache_valid any 1m;

# 缓存key规则

proxy_cache_key $scheme$proxy_host$request_uri;

# 添加缓存状态头

add_header X-Cache-Status $upstream_cache_status;

# 忽略缓存控制头

proxy_ignore_headers Cache-Control Expires;

# 缓存锁(防止缓存击穿)

proxy_cache_lock on;

proxy_cache_lock_timeout 5s;

}

}

}

浏览器缓存配置

location ~* \.(jpg|jpeg|png|gif|ico|css|js)$ {

expires 30d;

add_header Cache-Control "public, immutable";

}

location ~* \.(html|htm)$ {

expires 1h;

add_header Cache-Control "public, must-revalidate";

}

缓存清理策略

# 特定URL不缓存

location /api/realtime {

proxy_pass http://backend;

proxy_cache off;

}

# 根据cookie决定是否缓存

proxy_cache_bypass $cookie_nocache $arg_nocache;

proxy_no_cache $cookie_nocache $arg_nocache;

请求时序图

八、Nginx实现IP黑白名单

访问控制是保障系统安全的重要手段。

IP白名单配置

# 方式一:直接配置

location /admin {

allow 192.168.1.0/24;

allow 10.0.0.1;

deny all;

}

# 方式二:使用配置文件

# 创建 /etc/nginx/whitelist.conf

# 内容: allow 192.168.1.100;

location /admin {

include /etc/nginx/whitelist.conf;

deny all;

}

IP黑名单配置

# 创建 /etc/nginx/blacklist.conf

# deny 123.123.123.123;

# deny 45.45.45.0/24;

http {

include /etc/nginx/blacklist.conf;

server {

location / {

# 业务配置

}

}

}

基于地理位置的访问控制

# 需要安装GeoIP模块

http {

geoip_country /usr/share/GeoIP/GeoIP.dat;

map $geoip_country_code $allowed_country {

default no;

CN yes; # 只允许中国IP访问

US yes;

}

server {

location / {

if ($allowed_country = no) {

return 403;

}

}

}

}

九、Nginx跨域配置

现代Web应用中,跨域问题几乎是必然遇到的。Nginx可以优雅地解决这个问题。

完整跨域配置

location /api {

# 允许所有域名跨域

add_header Access-Control-Allow-Origin * always;

# 或指定特定域名

# add_header Access-Control-Allow-Origin https://example.com always;

# 允许的请求方法

add_header Access-Control-Allow-Methods 'GET, POST, PUT, DELETE, OPTIONS' always;

# 允许的请求头

add_header Access-Control-Allow-Headers 'DNT,X-CustomHeader,Keep-Alive,User-Agent,X-Requested-With,If-Modified-Since,Cache-Control,Content-Type,Authorization' always;

# 允许携带认证信息

add_header Access-Control-Allow-Credentials true always;

# 预检请求的缓存时间

add_header Access-Control-Max-Age 1728000 always;

# OPTIONS请求直接返回204

if ($request_method = 'OPTIONS') {

return 204;

}

proxy_pass http://backend;

}

动态CORS配置

map $http_origin $cors_origin {

default "";

"~^https?://(www\.)?example\.com$" $http_origin;

"~^https?://(www\.)?test\.com$" $http_origin;

}

server {

location /api {

add_header Access-Control-Allow-Origin $cors_origin always;

# 其他配置...

}

}

十、Nginx防盗链设计

防止其他网站直接引用你的图片、视频等资源,节省带宽成本。

基础防盗链配置

location ~* \.(gif|jpg|jpeg|png|bmp|swf|mp4|mp3)$ {

valid_referers none blocked server_names

*.example.com example.*

~\.google\. ~\.baidu\.;

if ($invalid_referer) {

return 403;

# 或返回防盗链图片

# rewrite ^/ /images/forbidden.png break;

}

expires 30d;

}

增强防盗链(Token验证)

location /protected/ {

secure_link $arg_md5,$arg_expires;

secure_link_md5 "$secure_link_expires$uri your_secret_key";

if ($secure_link = "") {

return 403;

}

if ($secure_link = "0") {

return 410; # 链接已过期

}

# 正常访问

}

生成访问链接的PHP示例:

$secret = 'your_secret_key';

$uri = '/protected/video.mp4';

$expires = time() + 3600; // 1小时后过期

$md5 = base64_encode(md5($expires . $uri . $secret, true));

$md5 = strtr($md5, '+/', '-_');

$md5 = str_replace('=', '', $md5);

$url = "http://example.com{$uri}?md5={$md5}&expires={$expires}";

十一、Nginx大文件传输配置

处理大文件下载和上传需要特殊配置,避免超时和内存溢出。

大文件下载优化

location /downloads {

# 限速配置(每个连接500KB/s)

limit_rate 500k;

# 下载前10MB不限速

limit_rate_after 10m;

# 超时时间

send_timeout 300s;

# 关闭代理缓冲(大文件直接传输)

proxy_buffering off;

# 支持断点续传

proxy_set_header Range $http_range;

proxy_set_header If-Range $http_if_range;

}

大文件上传配置

http {

# 允许上传大文件

client_max_body_size 1000m;

# 超时时间

client_body_timeout 300s;

# 临时文件目录

client_body_temp_path /var/nginx/temp;

server {

location /upload {

# 关闭请求体缓冲

proxy_request_buffering off;

# 读取超时

proxy_read_timeout 300s;

proxy_send_timeout 300s;

proxy_pass http://backend;

}

}

}

分片上传方案

location /upload/chunk {

client_max_body_size 10m; # 每个分片10MB

# 临时存储分片

upload_store /tmp/nginx_upload;

upload_store_access user:rw group:rw all:r;

# 设置上传文件的字段

upload_set_form_field $upload_field_name.name "$upload_file_name";

upload_set_form_field $upload_field_name.path "$upload_tmp_path";

# 合并完成后转发

upload_pass_form_field "^.*$";

upload_cleanup 400 404 499 500-505;

}

十二、Nginx配置SSL证书

HTTPS已成为标配,让我们看看如何配置SSL/TLS。

获取SSL证书

推荐使用Let's Encrypt免费证书:

# 安装certbot

sudo apt install certbot python3-certbot-nginx

# 自动配置

sudo certbot --nginx -d example.com -d www.example.com

手动配置HTTPS

server {

listen 80;

server_name example.com;

# HTTP自动跳转HTTPS

return 301 https://$server_name$request_uri;

}

server {

listen 443 ssl http2;

server_name example.com;

# 证书文件

ssl_certificate /etc/nginx/ssl/example.com.crt;

ssl_certificate_key /etc/nginx/ssl/example.com.key;

# SSL协议版本

ssl_protocols TLSv1.2 TLSv1.3;

# 加密套件

ssl_ciphers 'ECDHE-ECDSA-AES128-GCM-SHA256:ECDHE-RSA-AES128-GCM-SHA256';

ssl_prefer_server_ciphers on;

# 会话缓存

ssl_session_cache shared:SSL:10m;

ssl_session_timeout 10m;

# OCSP Stapling

ssl_stapling on;

ssl_stapling_verify on;

resolver 8.8.8.8 8.8.4.4 valid=300s;

# HSTS

add_header Strict-Transport-Security "max-age=31536000; includeSubDomains" always;

# 其他安全头

add_header X-Frame-Options DENY always;

add_header X-Content-Type-Options nosniff always;

add_header X-XSS-Protection "1; mode=block" always;

location / {

# 业务配置

}

}

证书自动续期

# 测试续期

sudo certbot renew --dry-run

# 添加定时任务

sudo crontab -e

# 添加: 0 3 * * * /usr/bin/certbot renew --quiet

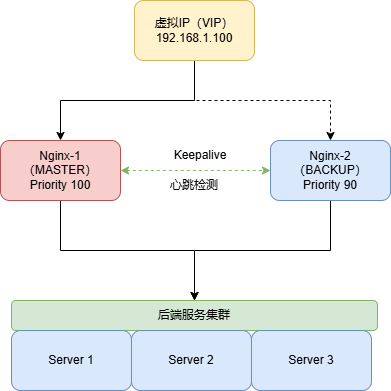

十三、Nginx的高可用

生产环境中,单点故障是不可接受的。Nginx高可用方案可以保证服务的连续性。

Keepalived实现主备切换

架构说明:

- 两台Nginx服务器(Master和Backup)

- 共享一个虚拟IP(VIP)

- Master故障时自动切换到Backup

安装Keepalived

sudo apt install keepalived -y

Master配置(/etc/keepalived/keepalived.conf)

global_defs {

router_id NGINX_MASTER

}

vrrp_script check_nginx {

script "/etc/keepalived/check_nginx.sh"

interval 2

weight -20

}

vrrp_instance VI_1 {

state MASTER

interface eth0

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass 1234

}

virtual_ipaddress {

192.168.1.100/24

}

track_script {

check_nginx

}

}

Backup配置

# 与Master类似,但修改:

state BACKUP

priority 90

健康检查脚本(/etc/keepalived/check_nginx.sh)

#!/bin/bash

counter=$(ps -C nginx --no-heading|wc -l)

if [ "${counter}" = "0" ]; then

systemctl start nginx

sleep 2

counter=$(ps -C nginx --no-heading|wc -l)

if [ "${counter}" = "0" ]; then

systemctl stop keepalived

fi

fi

启动服务

sudo systemctl start keepalived

sudo systemctl enable keepalived

十四、Nginx性能优化

这是整篇文章的重中之重,让我们系统地优化Nginx性能。

1. Worker进程优化

# 自动根据CPU核心数设置

worker_processes auto;

# 绑定worker到CPU核心,避免进程切换

worker_cpu_affinity auto;

# 每个worker的最大连接数

events {

worker_connections 10240;

use epoll; # Linux下使用epoll

multi_accept on; # 一次接受多个连接

}

2. 文件优化

http {

# 启用sendfile零拷贝

sendfile on;

# TCP优化

tcp_nopush on; # 数据包累积到一定大小再发送

tcp_nodelay on; # 小数据包立即发送

# 连接超时

keepalive_timeout 65;

keepalive_requests 100;

# 文件描述符缓存

open_file_cache max=10000 inactive=20s;

open_file_cache_valid 30s;

open_file_cache_min_uses 2;

open_file_cache_errors on;

}

3. 缓存优化

前面已经详细介绍,这里补充FastCGI缓存:

fastcgi_cache_path /var/cache/nginx/fastcgi

levels=1:2

keys_zone=fastcgi_cache:100m

max_size=2g

inactive=60m;

location ~ \.php$ {

fastcgi_cache fastcgi_cache;

fastcgi_cache_valid 200 60m;

fastcgi_cache_key "$scheme$request_method$host$request_uri";

add_header X-FastCGI-Cache $upstream_cache_status;

}

4. 日志优化

http {

# 定义日志格式

log_format main '$remote_addr - $remote_user [$time_local] '

'"$request" $status $body_bytes_sent '

'"$http_referer" "$http_user_agent" '

'$request_time $upstream_response_time';

# 缓冲日志写入

access_log /var/log/nginx/access.log main buffer=32k flush=5s;

# 静态文件不记录日志

location ~* \.(jpg|jpeg|png|gif|ico|css|js)$ {

access_log off;

}

}

5. 限流配置

http {

# 定义限流区域(每秒10个请求)

limit_req_zone $binary_remote_addr zone=req_limit:10m rate=10r/s;

# 连接数限制

limit_conn_zone $binary_remote_addr zone=conn_limit:10m;

server {

location /api/ {

limit_req zone=req_limit burst=20 nodelay;

limit_conn conn_limit 10;

}

}

}

6. 操作系统优化

编辑/etc/sysctl.conf:

# 增加文件描述符限制

fs.file-max = 999999

# TCP连接优化

net.ipv4.tcp_tw_reuse = 1

net.ipv4.tcp_keepalive_time = 600

net.ipv4.tcp_fin_timeout = 30

net.ipv4.tcp_max_tw_buckets = 5000

net.ipv4.ip_local_port_range = 1024 65000

net.ipv4.tcp_rmem = 4096 32768 262142

net.ipv4.tcp_wmem = 4096 32768 262142

net.core.netdev_max_backlog = 8096

net.core.somaxconn = 32768

# 启用BBR拥塞控制算法

net.core.default_qdisc = fq

net.ipv4.tcp_congestion_control = bbr

应用配置:

sudo sysctl -p

7. 性能监控

# 启用stub_status模块

location /nginx_status {

stub_status on;

access_log off;

allow 127.0.0.1;

deny all;

}

访问后可以看到:

Active connections: 291

server accepts handled requests

16630948 16630948 31070465

Reading: 6 Writing: 179 Waiting: 106

性能测试对比

使用ab工具测试(1000并发,10000请求):

优化前:

Requests per second: 1234.56 [#/sec]

Time per request: 81.02 [ms]

Failed requests: 23

优化后:

Requests per second: 8765.43 [#/sec]

Time per request: 11.41 [ms]

Failed requests: 0

性能提升超过7倍!

十五、写在最后

从Nginx的基本概念到高可用部署,从动静分离到性能调优,我们完成了一次全面的技术之旅。但这只是开始,Nginx的强大远不止于此。

持续学习建议:

- 深入研究Nginx模块开发,打造定制化功能

- 关注Nginx Plus商业版的新特性

- 实践OpenResty,结合Lua脚本实现更灵活的业务逻辑

- 学习云原生架构下的Nginx Ingress Controller

- 探索Nginx与微服务架构的最佳实践

实战经验总结:

经过多年生产环境的实践,我总结了几条黄金法则:

- 渐进式优化: 不要一次性修改所有配置,逐步测试每项优化的效果

- 监控先行: 在优化前建立完善的监控体系,用数据说话

- 备份配置: 每次修改前备份配置文件,出问题可以快速回滚

- 压测验证: 在生产环境应用前,务必在测试环境进行压力测试

- 文档记录: 详细记录每次配置修改的原因和效果

常见问题排查:

-

502 Bad Gateway

- 检查后端服务是否正常运行

- 确认proxy_pass地址正确

- 查看后端服务日志

-

504 Gateway Timeout

- 增加proxy_read_timeout

- 优化后端服务响应速度

- 检查网络连接状态

-

413 Request Entity Too Large

- 调整client_max_body_size

- 检查是否有WAF限制

-

高内存占用

- 检查缓存配置是否合理

- 减少worker_connections

- 优化缓冲区大小

-

CPU使用率高

- 检查是否开启了过高的gzip压缩级别

- 减少日志写入频率

- 优化正则表达式匹配

安全加固建议:

除了前面提到的配置,还应该注意:

# 隐藏Nginx版本信息

server_tokens off;

# 限制请求方法

if ($request_method !~ ^(GET|POST|HEAD|PUT|DELETE)$) {

return 405;

}

# 防止点击劫持

add_header X-Frame-Options "SAMEORIGIN" always;

# XSS防护

add_header X-XSS-Protection "1; mode=block" always;

# 禁止MIME类型嗅探

add_header X-Content-Type-Options "nosniff" always;

# CSP策略

add_header Content-Security-Policy "default-src 'self'" always;

# 限制User-Agent

if ($http_user_agent ~* (scrapy|curl|wget|python|nikto)) {

return 403;

}

性能优化checklist:

在部署到生产环境前,请确保完成以下检查:

- Worker进程数是否匹配CPU核心数

- 是否启用了sendfile和tcp_nopush

- 静态资源是否设置了合理的缓存时间

- 是否启用了Gzip压缩

- 是否配置了代理缓存

- 日志是否使用了缓冲写入

- 是否启用了文件描述符缓存

- 是否配置了连接复用

- 是否设置了合理的超时时间

- 是否实施了限流保护

- SSL配置是否采用了最新的安全标准

- 是否配置了健康检查

- 是否有完善的监控告警

- 备份方案是否已经测试

未来趋势展望:

随着技术的发展,Nginx也在不断演进:

HTTP/3支持: 基于QUIC协议的HTTP/3将带来更快的连接建立和更好的弱网络表现。Nginx 1.25+版本已经开始支持HTTP/3。

服务网格集成: 在Kubernetes环境中,Nginx作为Ingress Controller或Service Mesh的数据平面,扮演着越来越重要的角色。

边缘计算: 借助Nginx的高性能和灵活性,越来越多的边缘计算场景开始采用Nginx作为网关。

智能化运维: 结合AI技术,Nginx的配置优化、故障预测将变得更加智能化。

最后的话:

Nginx不仅是一个Web服务器,更是一个强大的流量处理平台。掌握Nginx,就掌握了构建高性能Web架构的核心技能。

这篇文章涵盖了Nginx从入门到精通的方方面面,但技术的学习永无止境。建议你:

- 动手实践: 在自己的服务器上逐一验证文中的配置

- 阅读官方文档: http://nginx.org/en/docs/

- 关注社区动态: 加入Nginx相关的技术社群

- 研究源码: 深入理解Nginx的实现原理

- 分享经验: 将你的实践经验分享给更多人

记住,没有银弹。每个系统都有其独特性,需要根据实际情况调整配置。保持好奇心,持续优化,你的系统性能一定会越来越好。

如果这篇文章对你有帮助,欢迎转发分享给更多需要的朋友。也期待在评论区看到你的实践经验和遇到的问题,让我们一起交流学习。

技术路漫漫,我们一起前行。

参考资源:

- Nginx官方文档: http://nginx.org/en/docs/

- Nginx配置生成器: https://www.digitalocean.com/community/tools/nginx

- Nginx性能测试工具: Apache Bench, wrk, siege

- 监控工具: Prometheus + Grafana, Nginx Amplify

- 学习社区: Nginx官方邮件列表, Stack Overflow

Q.E.D.