线上服务RT突然飙高几秒,但很快恢复正常,监控图上只留下一个尖刺。等你收到告警登上服务器时,现场早已“风平浪静”... 这种来无影去无踪的“性能幽灵”,你是否也曾遇到过?今天,我们将揭晓JDK内部隐藏的一个终极武器,它就像飞机的“黑匣子”,能帮你回溯时间,捕获那些转瞬即逝的性能元凶。

痛点:无法复现的“性能幽灵”

让我们先构建一个让所有Java工程师都头皮发麻的场景:

一个核心服务在线上平稳运行数周后,监控系统突然告警,报告P99延迟从50ms飙升到2秒,持续了不到10秒钟后又恢复了正常。你立即展开排查:

- 看GC日志:没有FGC,YGC也在正常范围内。

- 看CPU/内存:曲线只有一个小小的毛刺,看不出所以然。

- 看业务日志:只发现那几秒的业务处理变慢了,没有异常错误。

- 想用

arthas或profiler:当你终于连上服务器,问题早已消失,无法捕捉。

这个问题在测试环境怎么也无法复现,它就像一个“幽灵”,时不时出来骚扰你一下,让你寝食难安。怎么办?难道只能祈祷它不要再出现吗?

不,Oracle的工程师早已为我们准备好了答案。

揭秘“飞行记录仪”:Java Flight Recorder (JFR)

JFR (Java Flight Recorder) 早已存在于JDK中,但自 JDK 11 起,它被完全开源并作为一项标准功能免费提供,迎来了它的高光时刻。它是一个专为生产环境设计的、高性能、低开销的事件记录引擎。

你可以把它精确地理解为飞机的**“黑匣子”**:

- 持续记录:它在后台持续不断地记录着JVM内部和应用程序的各种低级别事件数据。

- 开销极低:官方宣称,在默认配置下,开启JFR带来的性能影响小于1%。这使得在生产环境7x24小时开启它成为可能。

- 数据全面:它记录的不是采样数据,而是真实的事件流,涵盖代码执行、锁竞争、GC、JIT编译、文件I/O、Socket I/O等方方面面。

为什么它的开销如此之低?

简单来说,它的设计哲学就是“极致地不打扰应用线程”。数据被暂存到每个线程的本地缓冲区(Thread Local Buffer),只有当缓冲区满了,才会有一次批量写入全局缓冲区的动作。这种设计避免了频繁的锁竞争和数据同步,对应用几乎无感知。

重要提示:关于 JDK 8

如果你正在使用广泛部署的 Oracle JDK 8,JFR 同样可用,但它当时属于商业特性 (Commercial Feature),默认是禁用的。

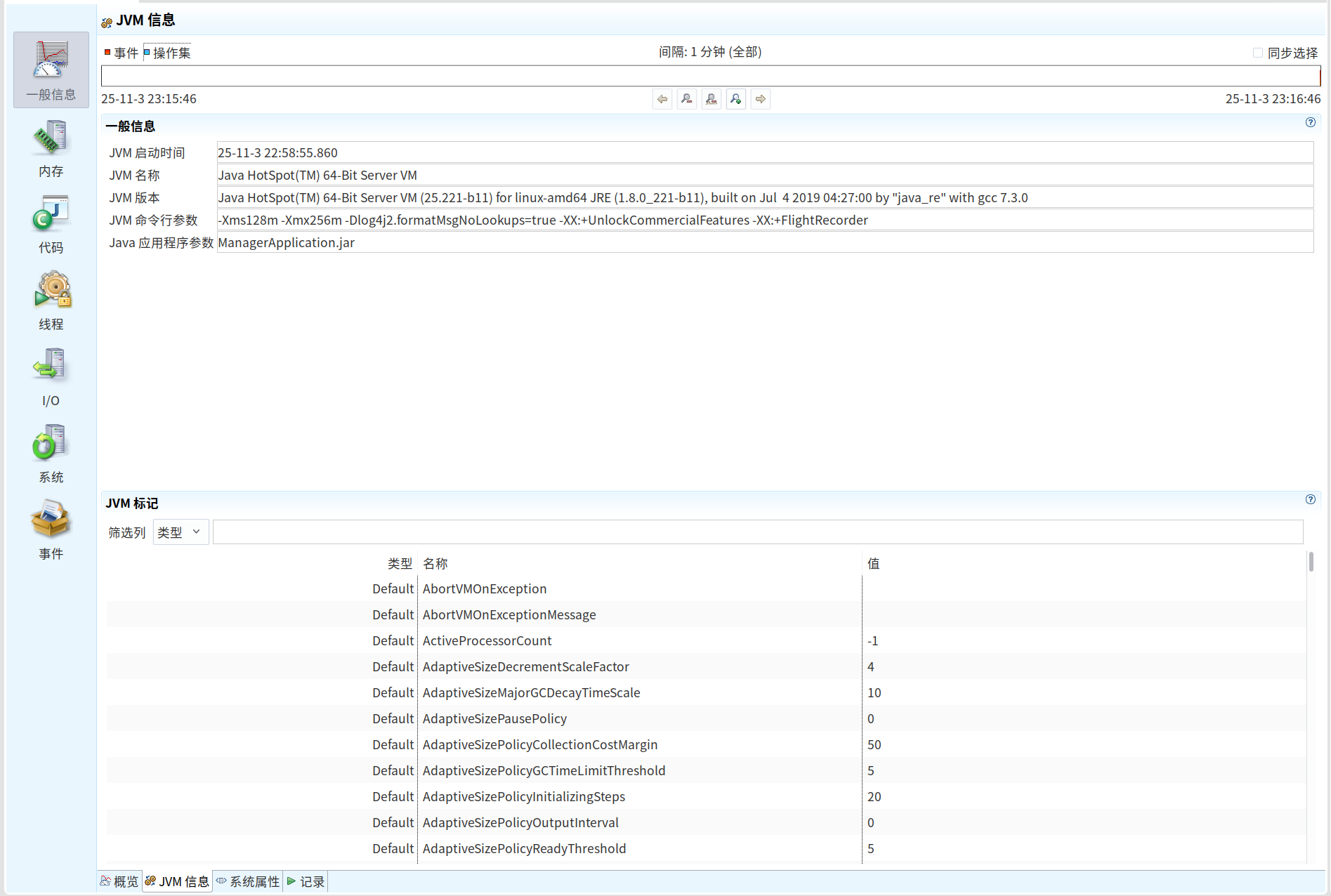

你必须在启动Java应用时,添加以下两个参数来显式启用它:

-XX:+UnlockCommercialFeatures -XX:+FlightRecorder

否则,当你直接对JDK 8进程使用jcmd JFR.start时,就会遇到Java Flight Recorder not enabled的错误。一旦通过上述参数启动,本文后续的所有操作对JDK 8完全适用!

实战演练:三步捕获“性能幽灵”

光说不练假把式。假设我们那个有“幽灵”问题的Java进程PID是12345。

第一步:动态开启记录,让子弹飞一会儿

这是JFR最强大的功能:无需重启JVM,我们就可以通过jcmd命令,随时对一个正在运行的进程(前提是已按需启用JFR)开启“飞行记录”。

# 对PID为12345的进程开启一个名为my_recording的记录

# 持续时间60秒,记录文件保存在 /tmp/my_recording.jfr

jcmd 12345 JFR.start name=my_recording duration=60s filename=/tmp/my_recording.jfr

执行命令后,JFR就会在后台默默工作。60秒后,一份包含这期间所有JVM事件的、名为 my_recording.jfr 的“黑匣子”文件就生成了。

Pro Tip: 你也可以让JFR一直运行,只保留最近一小时的数据,当问题发生时再手动dump下来,这对于捕捉偶发问题简直是神器!

为什么你在 JDK 8 中会报错?

你遇到的错误信息 Java Flight Recorder not enabled. Use VM.unlock_commercial_features to enable. 恰好揭示了历史原因:

在 JDK 11 之前,JFR 是 Oracle JDK 的一个商业特性 (Commercial Feature)。

这意味着:

- 它确实存在: JFR 的功能在 JDK 7u40 和 JDK 8 中就已经相当成熟和强大了。

- 默认不开启: 它被视为“付费功能”,所以默认是禁用的。

- 需要解锁: 你必须在JVM启动时,手动添加参数来“解锁”这些商业特性,并显式地启用 JFR。

所以,你的问题不在于 JFR 不存在,而在于你的Java进程启动时,没有授予它运行 JFR 的“许可”。

如何在 JDK 8 中正确启用并使用 JFR?

你需要做两件事:

第一步:修改应用的启动参数

在你的 java -jar your-app.jar 命令中,加入以下两个参数:

# -XX:+UnlockCommercialFeatures 解锁商业特性

# -XX:+FlightRecorder 启用JFR功能

java -XX:+UnlockCommercialFeatures -XX:+FlightRecorder -jar your-app.jar```

**只有带上这两个参数启动的Java进程,才能在运行时动态使用 JFR。**

**第二步:现在,`jcmd` 命令就可以正常工作了**

当你的应用以这种方式启动后,你再去执行之前的 `jcmd` 命令,就会发现它成功了:

```bash

# 找到你的进程 PID (假设还是 12345)

jcmd 12345 JFR.start name=my_recording duration=60s filename=/tmp/my_recording.jfr

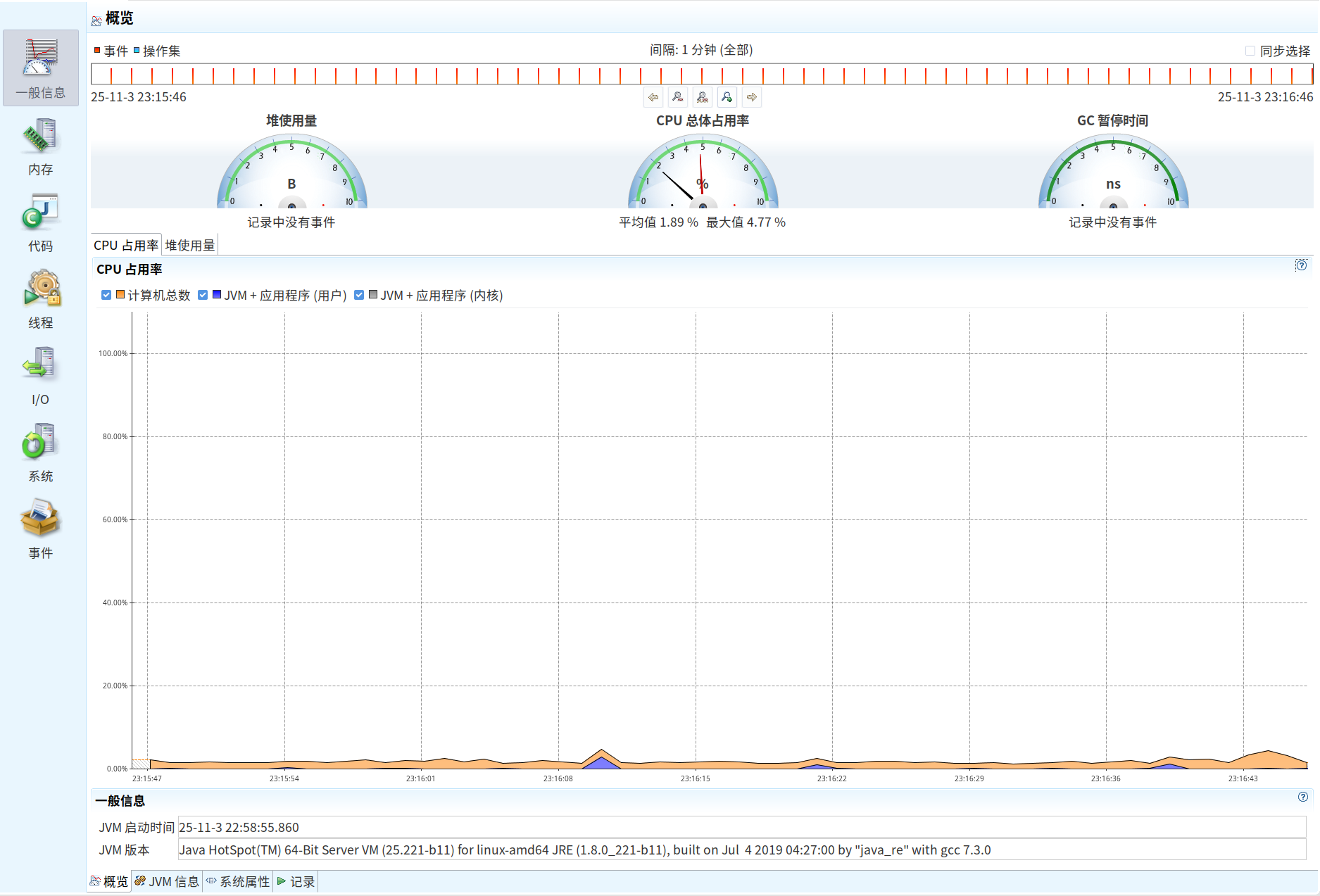

第二步:召唤“解码器” JDK Mission Control (JMC)

.jfr文件是二进制的,需要专门的工具来解读。这个官方“解码器”就是JMC (JDK Mission Control),一个独立的GUI分析工具,同样包含在JDK中(jmc命令)。

重要:JMC 在哪里?

从 JDK 11 开始,JMC 已经不再捆绑于 JDK 中,而是作为一个独立的应用程序提供。

JFR (记录器): 依然在 JDK 里,通过

jcmd使用。JMC (分析器): 需要你手动下载到你的本地电脑上。

你可以从 https://adoptium.net/jmc/ 下载适用于你操作系统的最新版本。下载解压后,直接运行其中的

jmc可执行文件即可。

所以,标准的流程是:

- 在服务器上,使用

jcmd生成.jfr文件。 - 将

.jfr文件从服务器下载到你的本地开发机。 - 在本地开发机上,打开你已独立安装的 JMC 程序,加载这个

.jfr文件进行分析。

!内存概览页面,包括垃圾收集、GC时间、GC配置等信息](https://cdn.dog.alianga.com/2025/11/04/318972bdfe381adc.png)

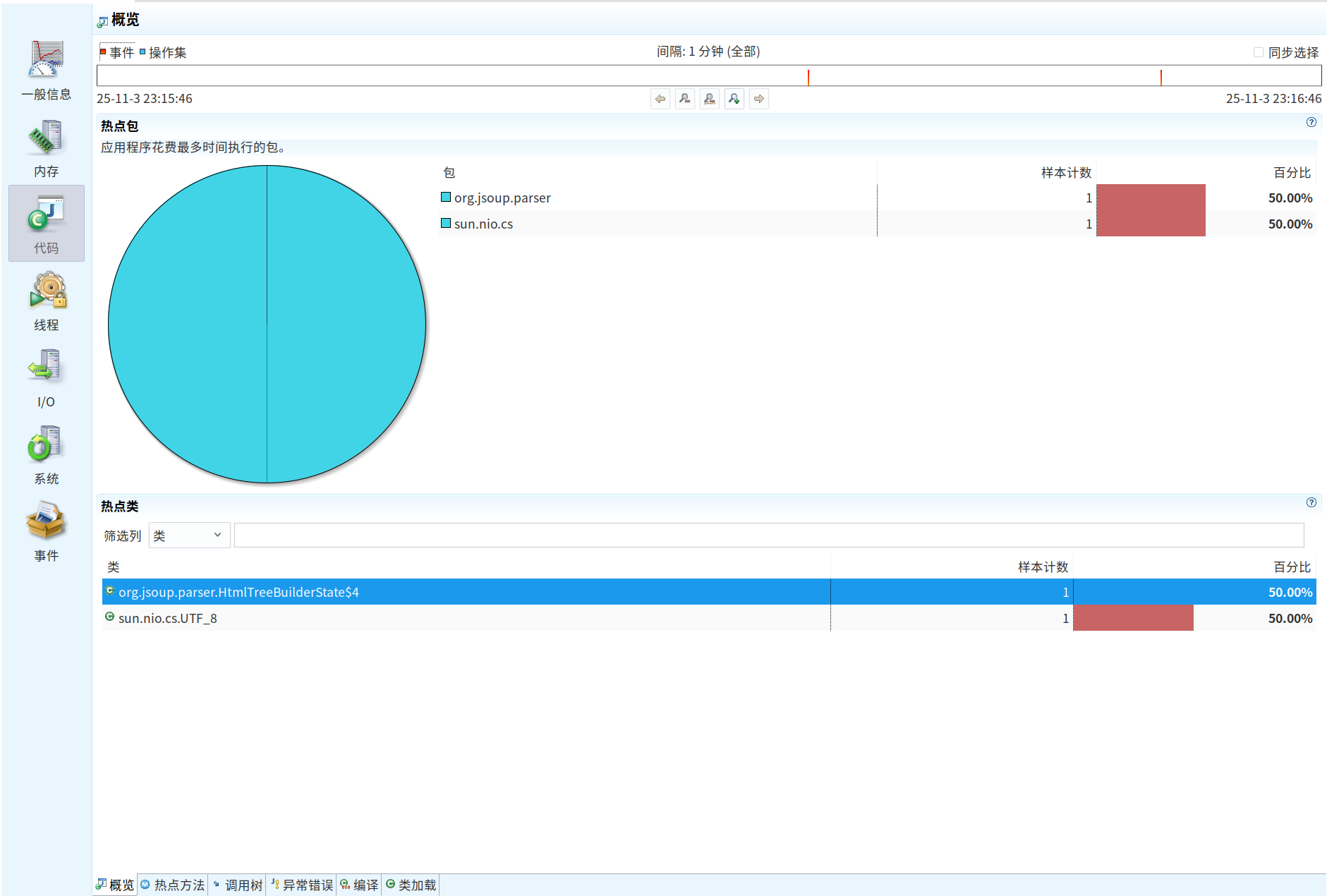

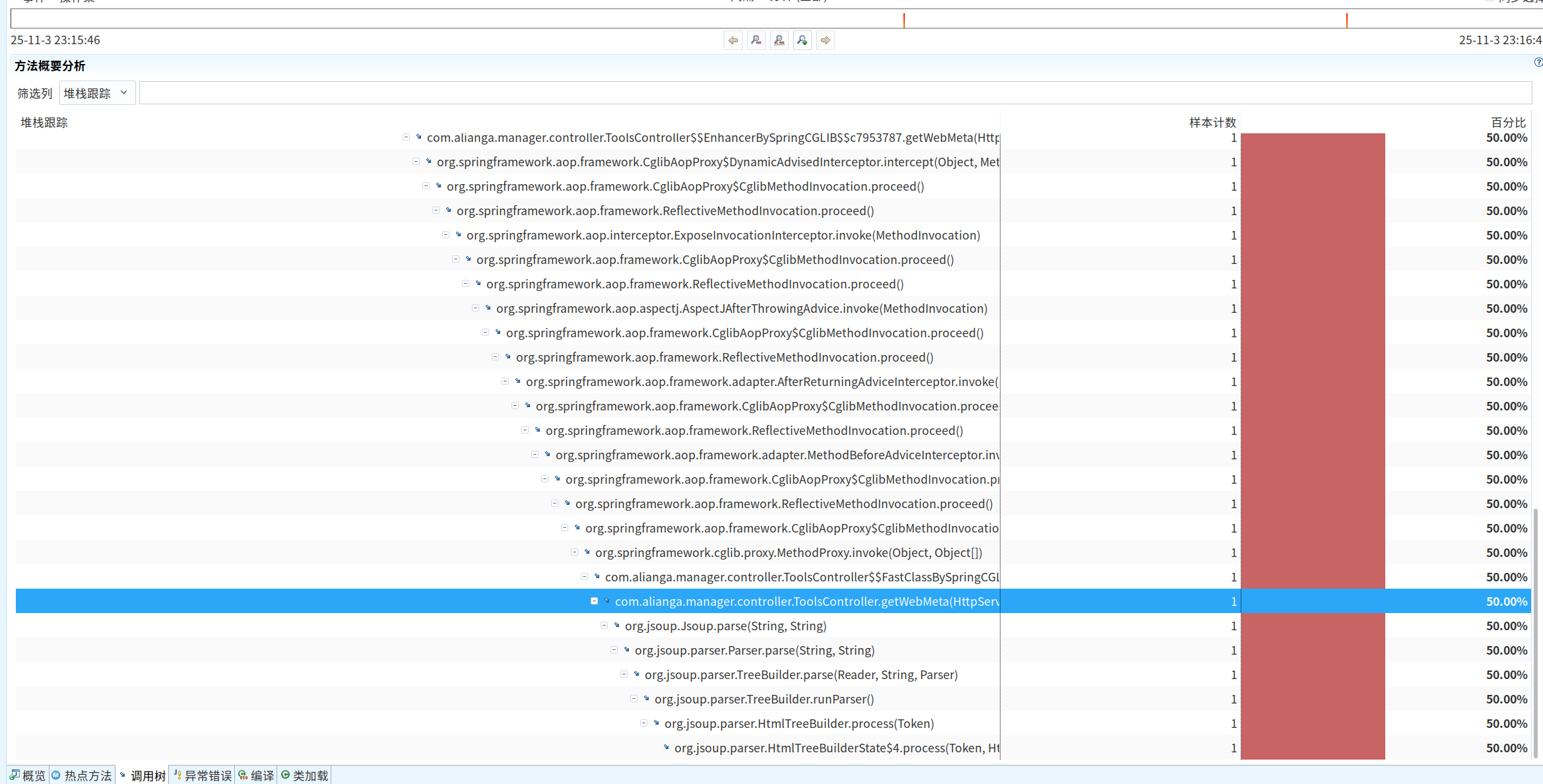

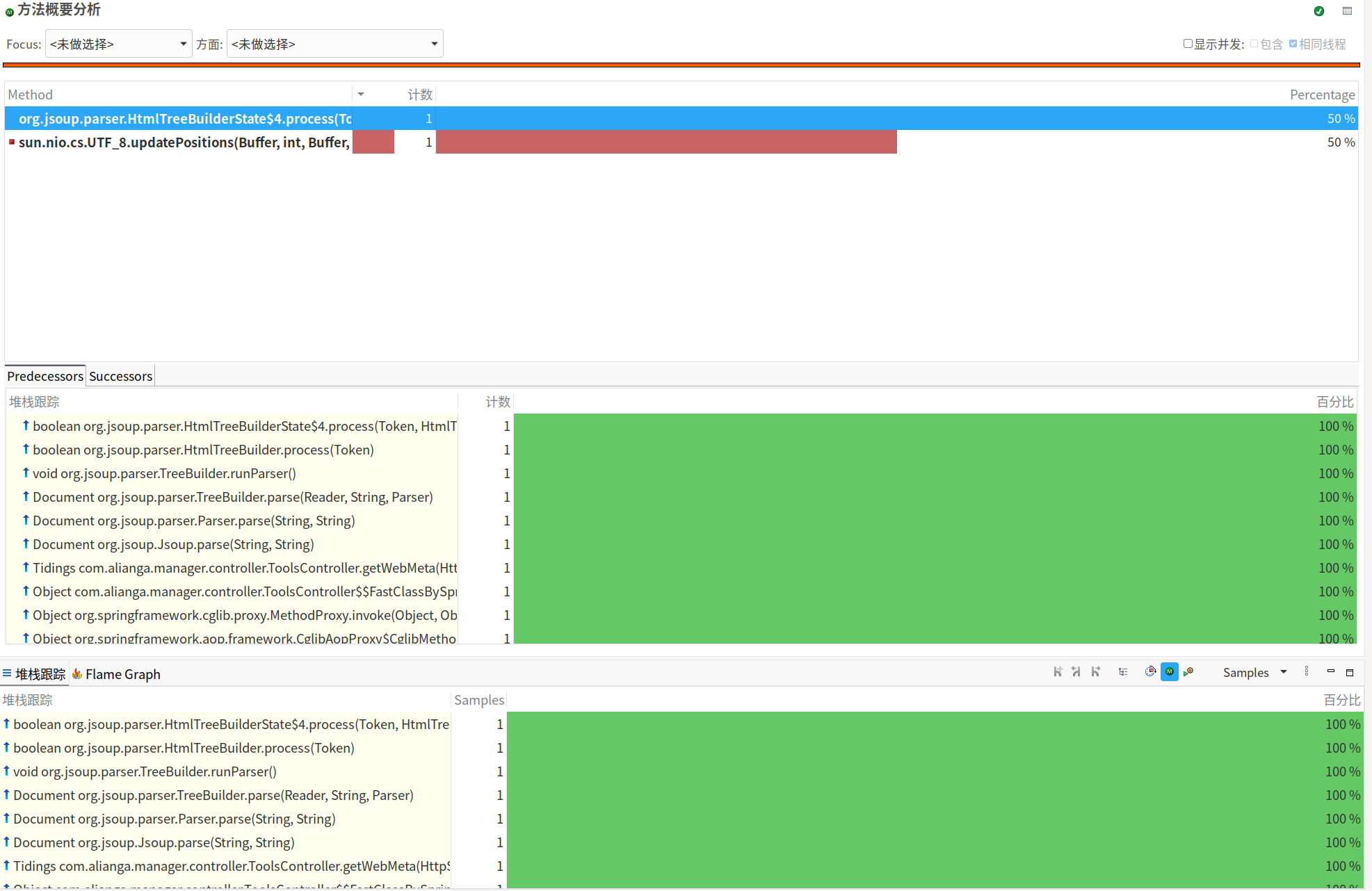

第三步:在JMC中“破案”

JMC的界面非常直观,它已经自动帮你把海量的事件数据归类整理好了。对于我们的“幽灵”问题,重点关注以下几个地方:

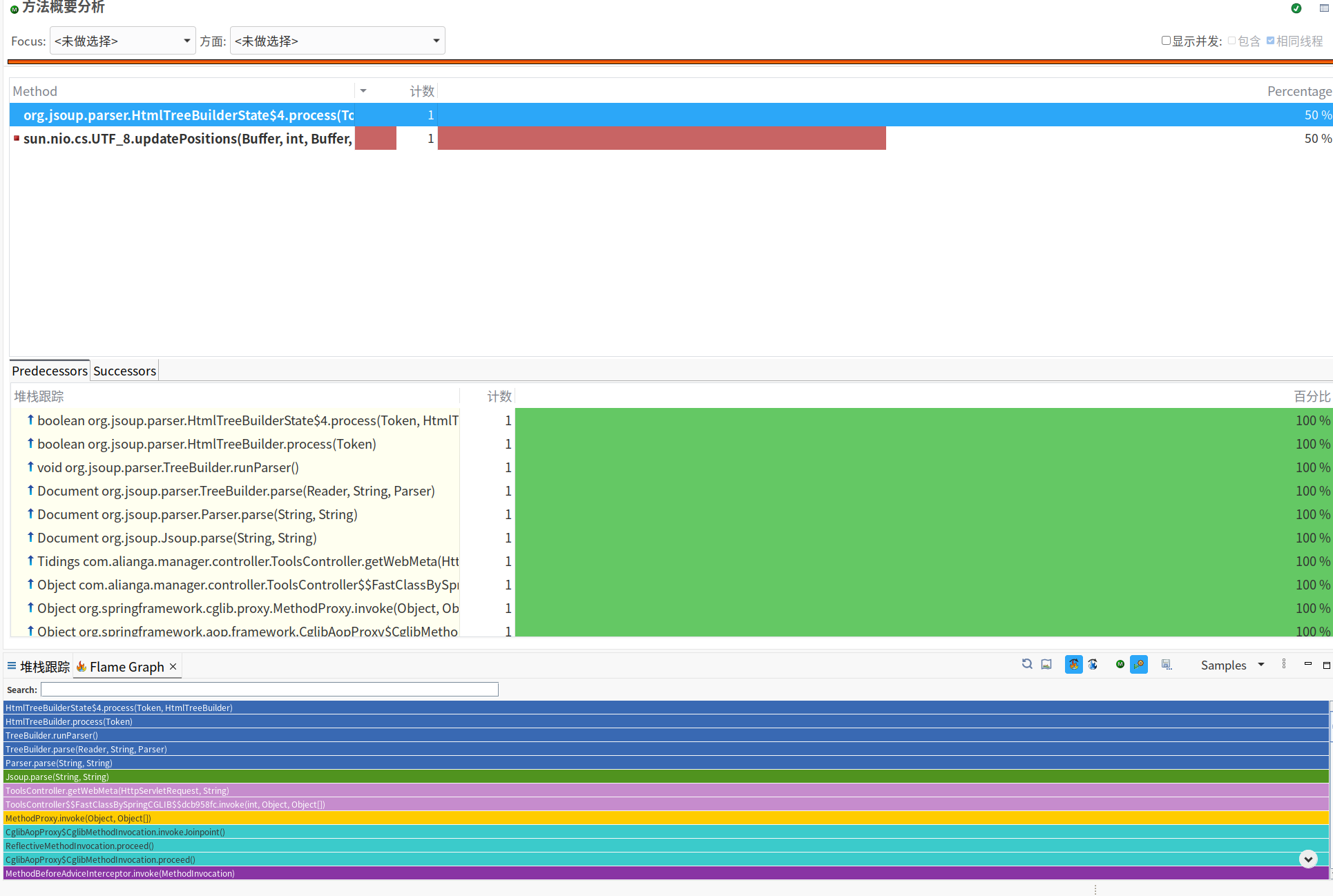

-

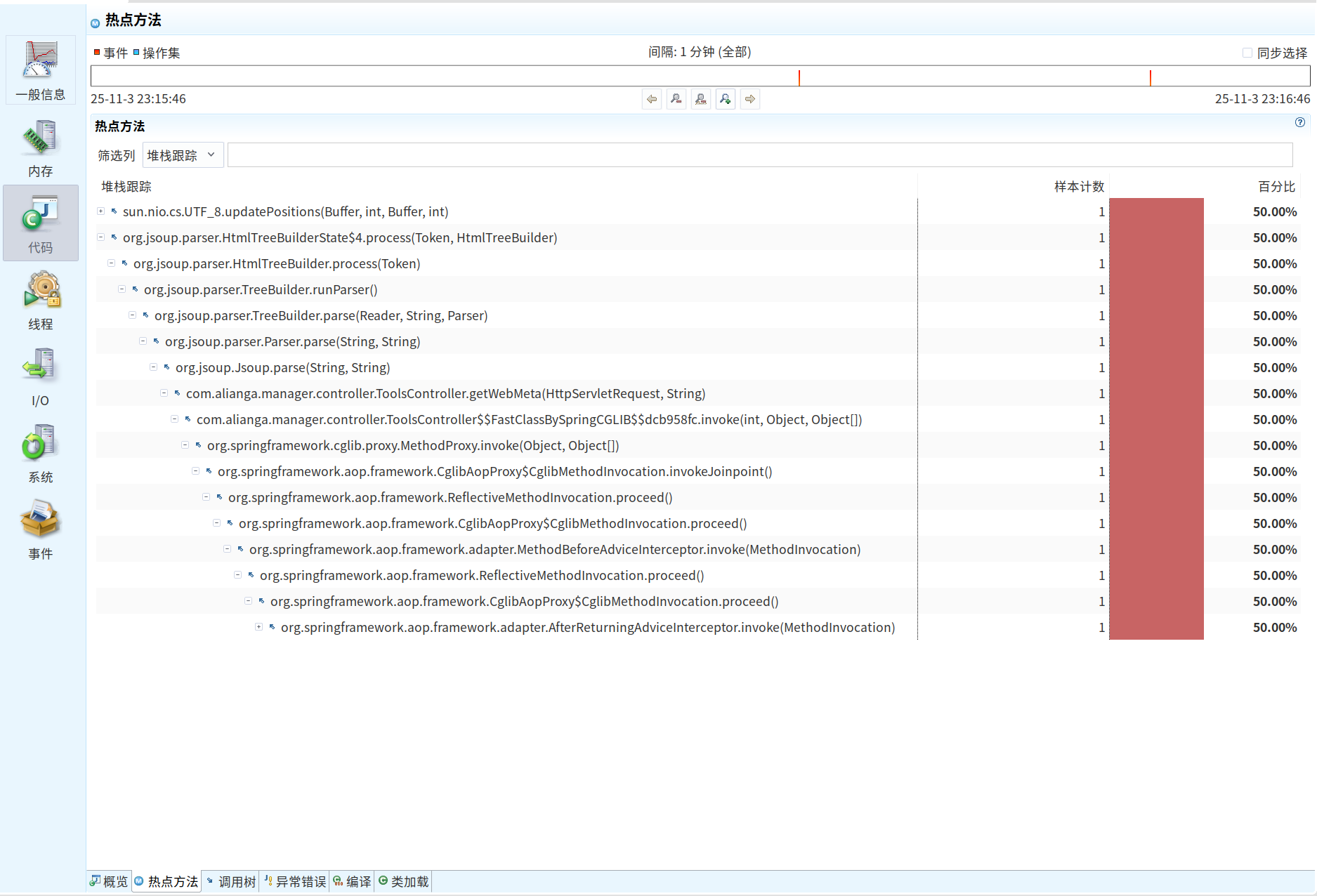

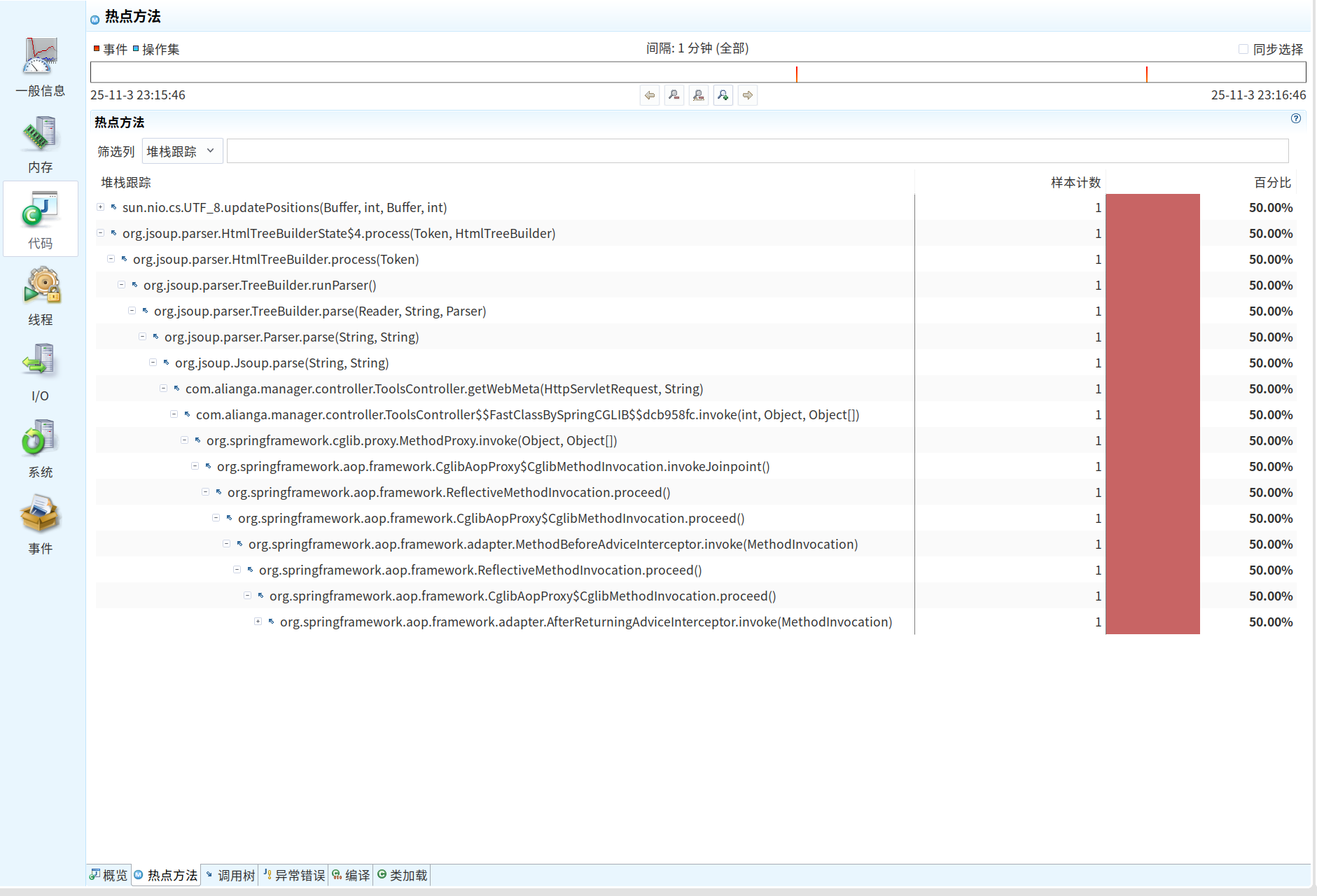

“代码” -> “热点方法”:

这里会用火焰图等形式,清晰地告诉你,在记录期间,哪些Java方法占用了最多的CPU时间。如果问题是CPU毛刺,元凶通常就在这里。 -

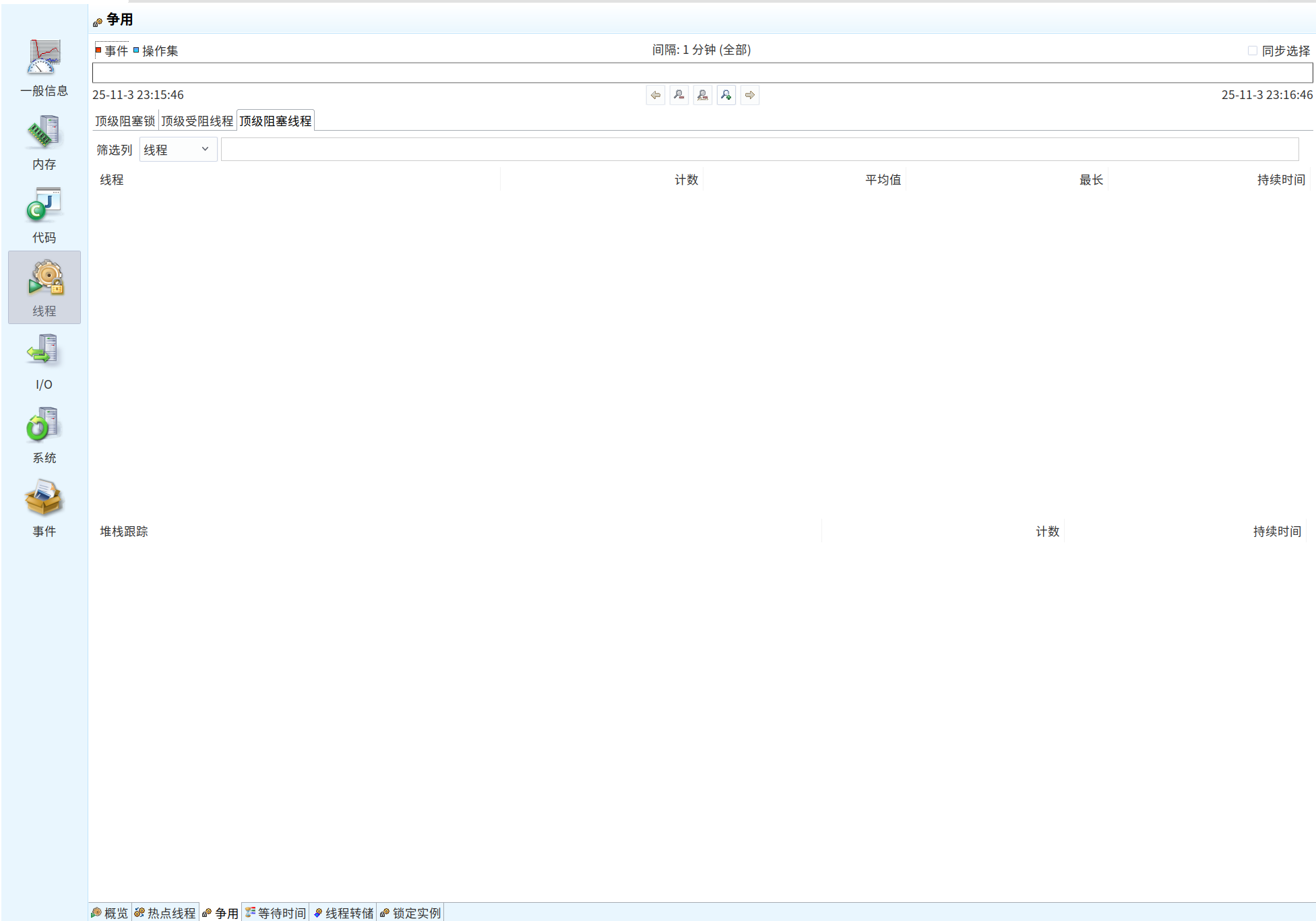

“线程” -> “锁争用”:

这是排查RT飙高的重点区域! 它会列出所有发生过竞争的锁,告诉你哪个线程在哪个代码点阻塞了多久,等待的是哪个线程持有的锁。很多“幽灵”问题,本质上都是某个不起眼的synchronized块或ReentrantLock在高并发下产生的激烈竞争。

-

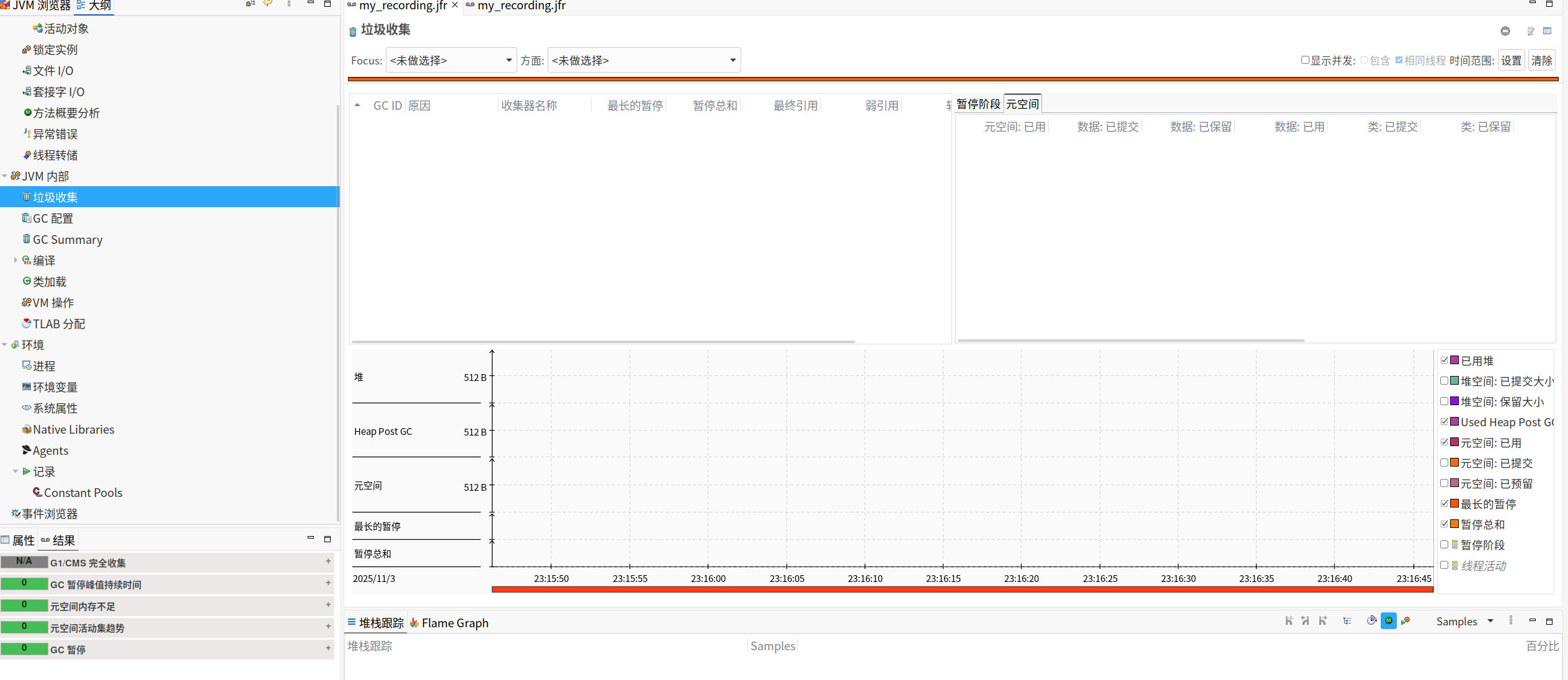

“JVM内部” -> “垃圾回收”:

这里提供了比GC日志更详细、更可视化的GC信息。你可以清晰地看到每一次GC的暂停时间、原因、以及内存分配的速率。有时,问题并非GC暂停本身,而是因为内存分配速率突然暴增,导致YGC频繁,从而影响了应用吞- 吐量。 -

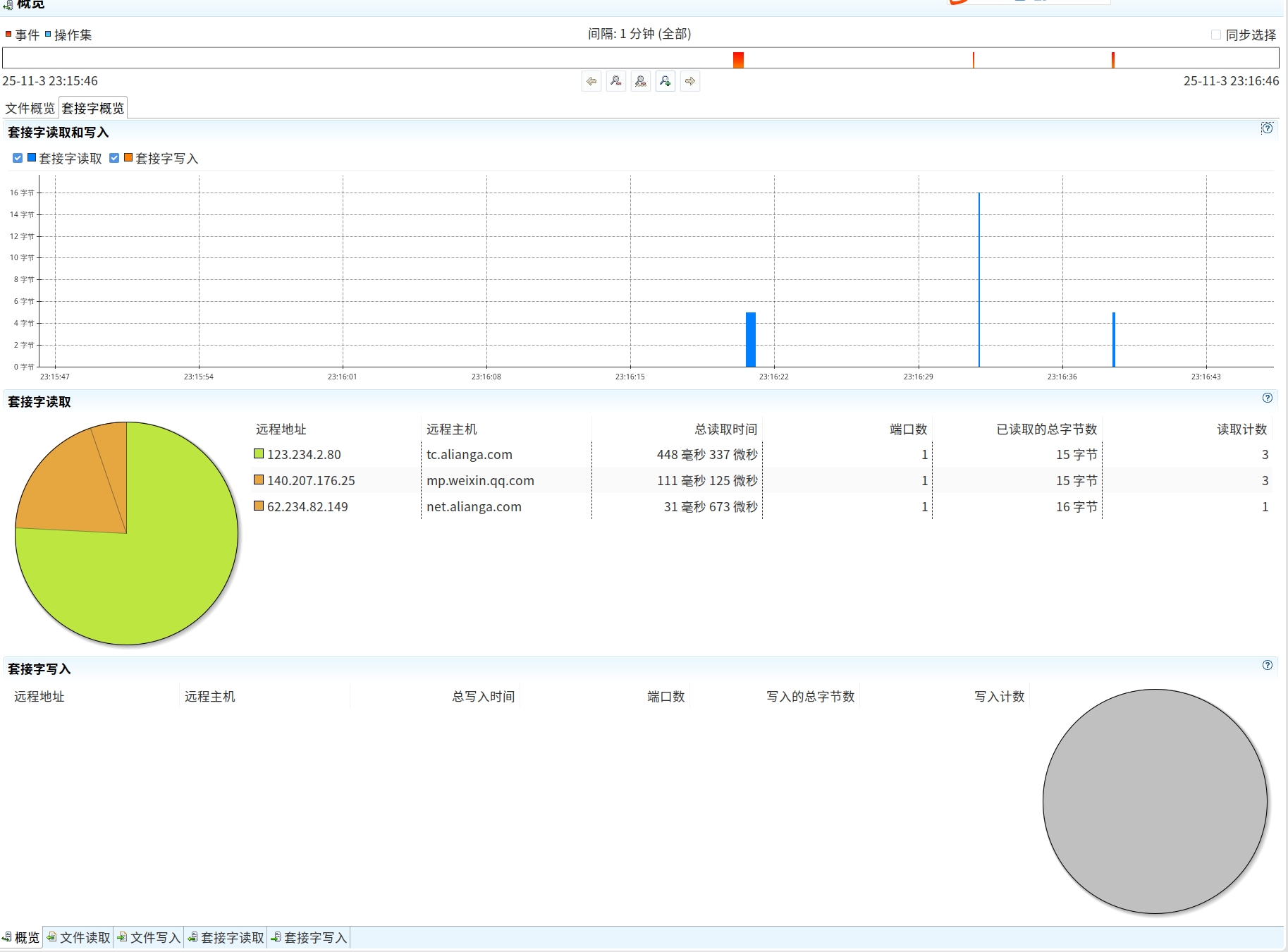

“I/O” -> “文件读写 / 套接字读写”:

如果你的应用是I/O密集型的,这里的视图会告诉你最耗时的文件和网络读写操作发生在哪个线程、哪个代码点。

通过在JMC中对这几个视图的分析,我们很大概率能定位到,之前那个RT飙高的“幽loating”,其实是在某个特定业务场景下,多个线程同时竞争一个全局缓存的锁导致的。而这个场景,恰好在压测时被忽略了。

写在最后

忘掉那些需要在生产环境小心翼翼使用的profiler吧。JFR + JMC 才是为现代Java应用量身打造的、生产环境首选的性能诊断工具。

- 能力:它让你拥有了“回溯时间”的超能力,去分析那些转瞬即逝的性能问题。

- 成本:自JDK 11起完全免费。在JDK 8中,你只需添加两个启动参数即可解锁。

- 风险:开销极低,为生产环境而生,安全可靠。

下一次,当你的Java服务再出现“性能幽灵”时,不要再犹豫。冷静地敲下 jcmd 命令,开启JFR,让“黑匣子”记录下一切。当硝烟散去,你就可以端着咖啡,在JMC中从容地复盘整个“案发现场”。

你还遇到过哪些诡异的线上性能问题?你是如何解决的?欢迎在评论区分享你的“探案”经历!

Q.E.D.